Запусти мощный ИИ прямо на своём ПК — без облаков и подписок

После свежих обновлений от NVIDIA и OpenAI сложные языковые модели теперь можно запускать полностью на собственном компьютере. Никаких облачных аккаунтов и ежемесячных платежей — всё, что потребуется, это видеокарта GeForce RTX с минимум 16 ГБ видеопамяти. Это настоящая революция: теперь продвинутый ИИ доступен прямо на рабочем столе — для офлайн-анализа документов, генерации кода или создания уникальных цифровых ассистентов.

Лучший выбор для большинства — модель gpt-oss-20b

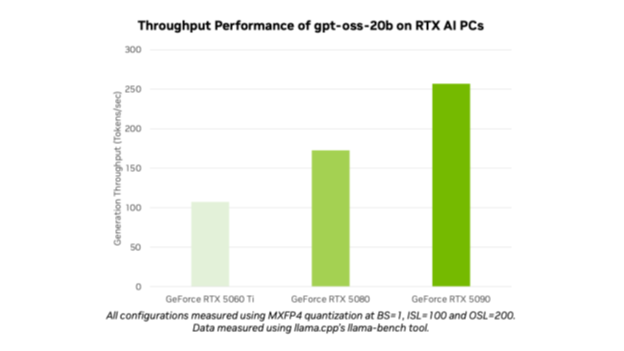

Оптимальная модель — это gpt-oss-20b с 20 миллиардами параметров. Она комфортно помещается в 16 ГБ видеопамяти, а значит, отлично работает на RTX 4080 и более мощных картах. В наших тестах RTX 5090 справлялась с примерно 256 токенами в секунду — этого достаточно для интерактивного общения с чат-ботами и небольшой обработки данных в реальном времени.

Если нужен реальный монстр — обратите внимание на gpt-oss-120b с 120 миллиардами параметров. Такая модель требует примерно 80 ГБ видеопамяти и способна работать на профессиональном «железе» уровня NVIDIA Blackwell GB200 NVL72, которое умеет обрабатывать свыше 1,5 миллиона токенов в секунду и обслуживать десятки пользователей одновременно. Для большинства домашних пользователей это пока слишком сложно, зато для крупных компаний — оптимальный выбор.

Какой софт выбрать для запуска ИИ

Чтобы запустить эти модели локально, есть три основных варианта:

-

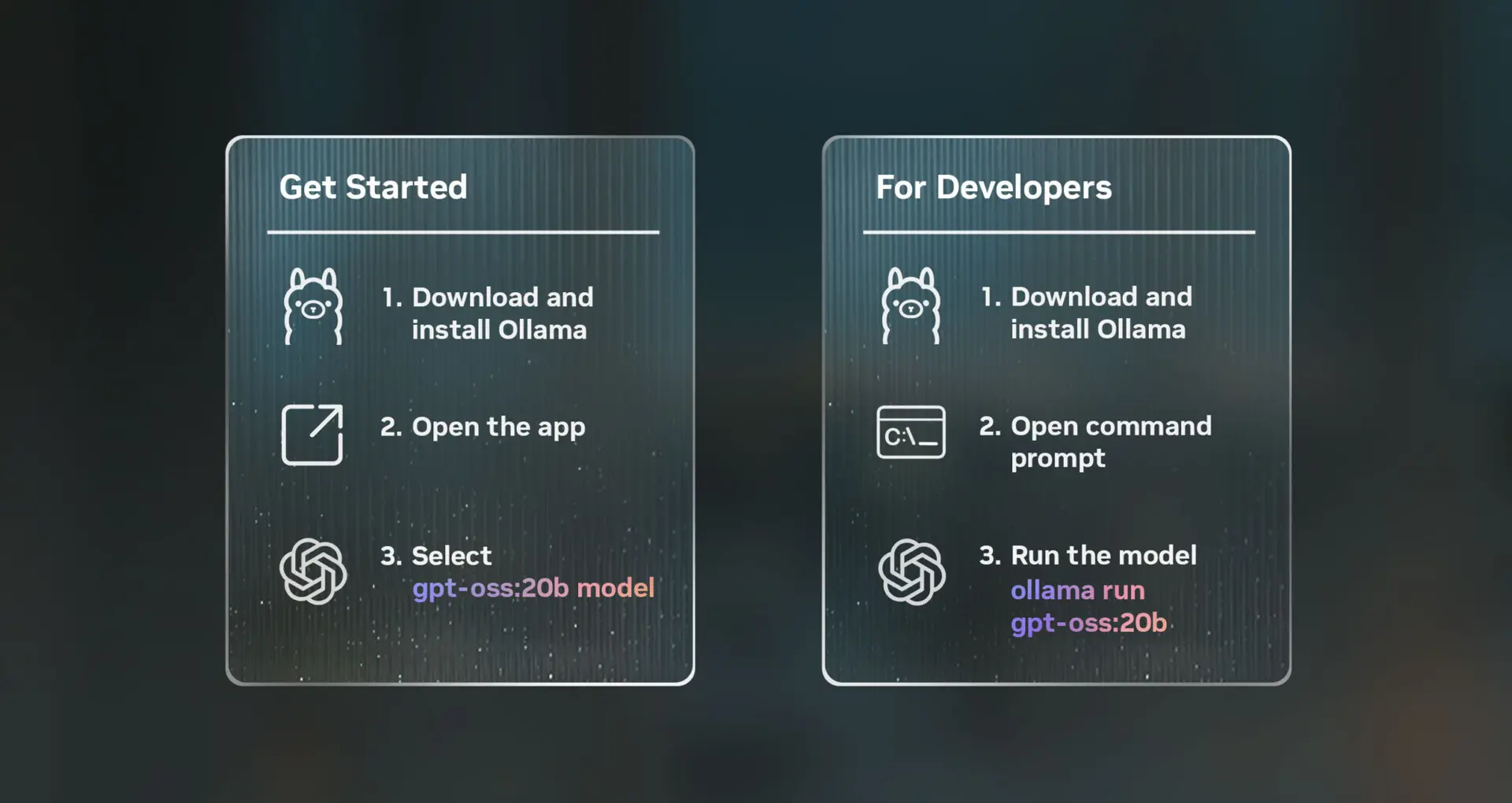

Ollama — самый простой способ. Просто выберите модель, запустите чат, и voilà — можно общаться. Программа поддерживает загрузку PDF-документов и длинных инструкций, благодаря чему бот лучше понимает контекст и выдаёт связные ответы.

-

Microsoft AI Foundry Local — для разработчиков, которые хотят полный контроль. Построен на базе ONNX Runtime и использует CUDA и TensorRT для максимальной производительности на GPU. Если вы планируете интегрировать ИИ в своё приложение — отличный выбор.

- llama.cpp с оптимизациями NVIDIA — для поклонников открытого кода. Поддерживает Flash Attention, ускорение через CUDA Graph и новый числовой формат MBFP4, что значительно повышает производительность. Настройка потребует больше усилий, но выигрыш в скорости стоит того.

Почему стоит запускать ИИ локально

Это не просто технологический трюк — у локального ИИ есть реальные преимущества:

-

Забудьте о подписках и ограничениях по трафику.

-

Конфиденциальные данные не покидают ваш компьютер — что критично для банков, медицины и государственных структур, где требования по безопасности и соответствию нормативам очень строгие.

- Полный контроль над моделями: можно их дообучать, создавать специализированных ассистентов и интегрировать в корпоративные системы.

Как начать работу с ИИ на своём ПК

-

Убедитесь, что у вас есть видеокарта серии RTX с минимум 16 ГБ видеопамяти (например, RTX 4080 или лучше).

-

Выберите и установите удобный софт: Ollama для быстрого старта, AI Foundry для разработки или llama.cpp для опытных пользователей.

-

Скачайте весовые файлы модели — gpt-oss-20b для домашнего использования или gpt-oss-120b для мощной серверной станции — и настройте окружение.

- Экспериментируйте: загружайте документы, создавайте собственные промты (запросы) или пишите код для своего ИИ-ассистента.

Доступность в России и цены

Большинство современных видеокарт RTX с 16 ГБ и выше доступны на российском рынке, хоть и с учётом колебаний цен и дефицита. Цена RTX 4080 сейчас стартует примерно от 130–150 тысяч рублей, а RTX 5090 и более мощные решения — выше 250 тысяч рублей. Профессиональное оборудование для запуска моделей с сотнями миллиардов параметров, такое как Blackwell GB200, в России практически недоступно частным лицам и используется в дата-центрах крупных организаций.

Мнение эксперта

«Запускать ИИ локально — это ключ к полной независимости от облачных сервисов, — считает ИТ-эксперт Сергей Иванов. — Особенно это актуально для бизнеса, где важна безопасность данных и скорость отклика. Технология становится всё доступнее, и в ближайшие годы мы увидим рост пользовательских решений на основе таких моделей прямо на домашнем или офисном ПК.»

Локальный ИИ — это не будущее, это уже сейчас. Если вы готовы инвестировать в мощную видеокарту и освоить новые инструменты, перед вами открываются невиданные возможности для работы с искусственным интеллектом, не завися от сторонних сервисов.